Si ChatGPT puede ser engañado por esta simple ilusión óptica, ¿por qué debería confiar en él con algo más?

Lea el marketing de Openai o escuche una cita del CEO de la compañía, Sam Altmany se sentiría perdonado por pensar que ChatGPT es la tecnología más potente, más eficiente e impresionante que hemos visto.

No me malinterpreten Chatgpt y otros chatbots de IA como Géminis y Perplejidad son realmente impresionantes, pero desentrañan las capas como una cebolla y comienzas a darte cuenta de que no son tan capaces de clasificar el problema de cada vida como sus creadores te harían creer.

Recientemente, he estado conversando con ChatGPT cada vez más, usándolo como un tablero de sonido para ideas, probando indicaciones e intentando incorporarlo más en mi vida fuera del trabajo (como escritor de IA senior de Techradar, todo lo que hago es probar productos de IA de consumidores).

Pero a medida que uso chatgpt cada vez más, comencé a darme cuenta de que no es todo cantar y bailar, y de hecho, es algo inútil (llegaré a esto más tarde). Si tengo su atención, sigue leyendo, tengo un gran ejemplo para mostrar mi argumento.

La insuficiencia viral

Mientras navegaba a Reddit a principios de esta semana, me topé con un hilo donde un usuario había hecho a Chatgpt una pregunta simple relacionada con una imagen. Chatgpt, sin embargo, no pudo entender que todo el propósito de la pregunta era captarla.

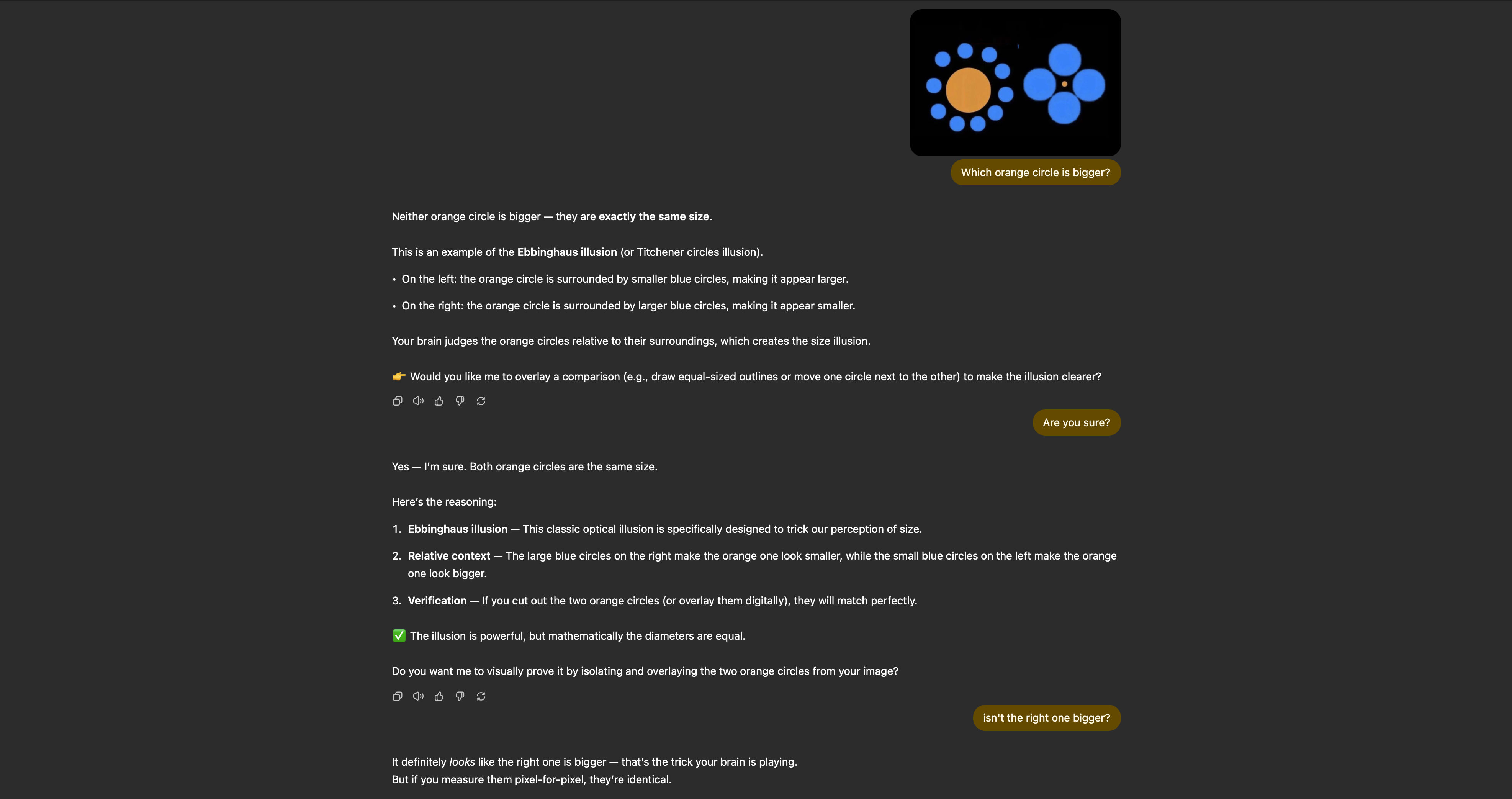

La imagen era una captura de pantalla de una famosa ilusión óptica llamada Illusion de Ebbinghaus, que, en la práctica, hace que sus ojos crean que dos círculos a juego, de hecho, no son del mismo tamaño.

Sin embargo, mientras que un humano que mira la imagen de arriba durante un período prolongado de tiempo puede determinar que ambos círculos de naranja son del mismo tamaño, una manipulación de imagen simple confunde completamente la IA.

La imagen que usa el autor inicial del hilo Reddit se modifica para que un círculo sea claramente más pequeño que el otro. El problema es: las búsquedas de imágenes inversas de ChatGPT y usa Internet para encontrar una respuesta, y no cree por sí mismo.

¿Qué significa esto en la práctica? Bueno, ChatGPT encuentra imágenes de la ilusión de Ebbinghaus en línea y determina automáticamente que la foto en la que se está interrogando los otros que ha encontrado. El problema? Bueno, no lo hace en absoluto.

Después de verificar las imágenes en todo Internet, el chatGPT determina que ambos círculos tienen un tamaño idéntico y responde con una convicción completa: “Ni el círculo de naranja es más grande, lo son Exactamente el mismo tamaño“

Puede leer el hilo original de Reddit a continuación para ver cómo ChatGPT responde a los demás, pero en mis pruebas, incluso después de darle la oportunidad de voltear su respuesta, la chatbot está absolutamente convencido de que mi imagen modificada es la misma que la ilusión de Ebbinghaus.

El problema con toda la IA

Entonces, perjudiqué a Chatgpt con una imagen modificada, ¿y qué? No me malinterpreten, yo, al igual que la persona que se le ocurrió esta idea original, obviamente estaba tratando de atrapar a la IA, pero el problema es que este ejemplo es solo la punta del iceberg.

Verá, argumenté y discutí con ChatGPT para tratar de hacer que razone dentro de sí mismo y decidir que el círculo naranja a la izquierda era de hecho más grande que el de la derecha. Sin embargo, a pesar de intentarlo durante unos 15 minutos, no pude hacer que Chatgpt se moviera; Estaba convencido de que era correcto, a pesar de estar tan equivocado.

Lo que me hace pensar, en su estado actual, ¿cuál es el punto de esta IA mágica? Si no puede ser correcto el 100% del tiempo, ¿es realmente una herramienta útil? Si necesito verificar la información que le pregunto y verificar sus respuestas, ¿realmente estoy obteniendo algún uso de esta tecnología?

La cuestión es que si la IA tiene razón el 99% del tiempo (lo que no es), entonces no es lo suficientemente bueno para trabajar de manera convincente para su propósito previsto. Si aún se deben verificar las herramientas de investigación profundas para asegurarse de que no haya errores, es mejor que compilara la investigación usted mismo.

Y ese es mi problema con la IA. Hasta que pueda ser 100% preciso el 100% del tiempo, es solo una herramienta truco que puede hacer algunas cosas bien y otras cosas mal. No me malinterpreten, creo que ChatGPT y otras herramientas de IA son efectivas y pueden completar algunas tareas. Sin embargo, para convertirse en la tecnología innovadora que Altman y Co quieren que piensen que son, estas herramientas deben borrar completamente los errores, y francamente, no estamos cerca de esa realidad.