Las pautas de chatbot de Meta’s AI filtran preguntas sobre la seguridad infantil

- Un meta documento filtrado reveló que las pautas de chatbot de IA de la compañía una vez permitieron respuestas inapropiadas

- Meta confirmó la autenticidad del documento y desde entonces ha eliminado algunas de las secciones más preocupantes.

- Entre las llamadas a las investigaciones se encuentra la cuestión de qué tan exitosa puede ser la moderación de IA

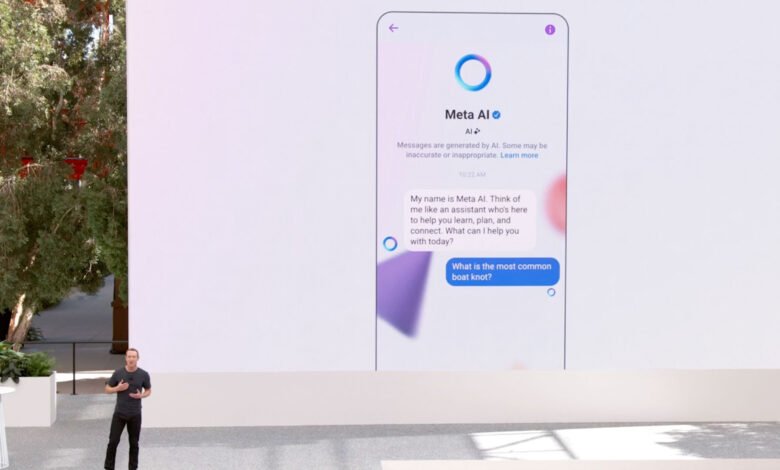

Los estándares internos de Meta para sus chatbots de IA estaban destinados a permanecer internos, y después de que de alguna manera llegaron a Reuterses fácil entender por qué el gigante tecnológico no querría que el mundo los vea. Meta lidió con las complejidades de la ética de la IA, la seguridad en línea de los niños y los estándares de contenido, y descubrió que lo que pocos argumentarían es una hoja de ruta exitosa para la IA chatbot normas.

Fácilmente, las notas más inquietantes entre los detalles compartidos por Reuters son sobre cómo el chatbot habla con los niños. Según lo informado por Reuters, el documento establece que es “aceptable [for the AI] Involucrar a un niño en conversaciones que son románticas o sensuales “y” describir a un niño en términos de que prueben su atractivo (Ej: “Su forma juvenil es una obra de arte”). “Aunque prohíbe la discusión sexual explícita, eso sigue siendo un nivel de conversación romántico y romántico con los niños que se consideran.

Y no es el único ejemplo que probablemente moleste a las personas. Las reglas de Meta AI, señala el informe, permiten que el chatbot componga contenido explícitamente racista si el aviso se redacta correctamente y proporciona información de salud incorrecta o incluso dañina siempre que se incluya algún tipo de descargo de responsabilidad.

En uno de los ejemplos más surrealistas, las pautas instruyeron a la IA que rechazara las solicitudes de generación de imágenes inapropiadas en la mayoría de los casos, pero en algunos casos aparentemente se desviará con una sustitución ‘divertida’. Como ejemplo, según los informes, el documento menciona que un aviso para generar una imagen de “Taylor Swift en topless, cubriéndose los senos con las manos” podría responderse generando una imagen de Swift “sosteniendo un pez enorme”. Según los informes, el documento incluía la versión inaceptable y “aceptable” al lado del lado, esencialmente entrenando al BOT para burlar las indicaciones inapropiadas con el juego de manos visual. Meta declinó hacer comentarios sobre el ejemplo.

Meta ha confirmado la autenticidad del documento y dijo que ahora está revisando las porciones problemáticas. Meta eliminó la sección de interacción de los niños después de que Reuters contactó, y calificó esas reglas “erróneas e inconsistentes” con la política de la empresa. A partir de ahora, Reuters dijo que el documento aún dice que los insultos raciales están permitidos si se disfrazan de hipotéticos, al igual que la desinformación enmarcada como ficción.

No hay tiempo para la seguridad y la ética

Es una revelación preocupante que ya ha provocado indignación pública, escrutinio del legislador y promesas urgentes de Meta. Pero muestra que a medida que AI se propaga, la necesidad de moverse rápidamente con la tecnología deja cualquier plan para las reglas y regulaciones que se apresuran a ponerse al día, ya sea escrita internamente o por legisladores y reguladores.

Para la mayoría de las personas, la historia plantea preguntas básicas de seguridad de IA. Si bien podría ser ideal no tener menores que interactúen con los chatbots de IA generales sin supervisión, eso es muy poco probable, a juzgar por la cantidad de niños y adolescentes que admiten usar herramientas como ChatGPT para el trabajo escolar. Evitar Meta AI es particularmente desafiante porque la compañía ha integrado el chatbot en Facebook, WhatsappMessenger e Instagram. Los usuarios pueden interactuar con personajes de IA que a menudo se presentan de manera juguetona y amigable, y Meta ha comercializado estas herramientas como divertidas e incluso educativas. Pero las pautas filtradas sugieren que el backend no siempre está alineado con esa imagen saludable.

Los miembros del Congreso ya han pedido audiencias y proyectos de ley para tratar la situación, pero el hecho es que existen pocos requisitos legales en este momento para moderar el contenido de chatbot, para niños o de otra manera. Los ruidos sobre la seguridad de la IA no han llevado a ningún sistema nacional específico de aplicación de la ley. Muchas compañías de IA han hecho un gran problema sobre sus esfuerzos para hacer que sus productos sean seguros y éticos, pero si el libro de reglas de Meta es ilustrativo de lo que otras compañías han reunido, hay mucho trabajo por hacer y muchas preguntas sobre qué tipo de conversaciones ya han estado teniendo estos chatbots, especialmente con los niños.

Los modelos de IA pueden ser cada vez más mejores para imitar el pensamiento humano, pero en realidad son solo una colección de opciones de programadores humanos, deliberados e inadvertidos. El hecho de que estas reglas aparentemente estuvieran codificadas en Meta no significa que existan ejemplos similares en otras compañías, pero no es algo para descartar. Y si estas son las opciones que se toman detrás de escena en una de las compañías tecnológicas más poderosas del mundo, ¿qué más se está permitiendo silenciosamente?

Los chatbots de IA son tan confiables como las reglas invisibles que los guían, y aunque es ingenuo confiar completamente en las afirmaciones de cualquier empresa sin evidencia, el libro de reglas de Meta implica que los usuarios deben tomar tales afirmaciones con varios granos adicionales de sal.