La arquitectura ACF-S y Emfasys de Enfabrica podría cambiar la forma en que AI los grupos procesan decenas de miles de chips de manera eficiente

- La adquisición de Nvidia lleva a los ingenieros de Enfabrica directamente a su ecosistema de IA

- Emfasys Chassis agrupa hasta 18 tb de memoria para grupos de GPU

- La tela de memoria elástica libera HBM para tareas de IA sensibles al tiempo de manera eficiente

NvidiaLa decisión de gastar más de $ 900 millones en Enfabrica fue una sorpresa, especialmente cuando vino junto a un separado Inversión de $ 5 mil millones en Intel.

De acuerdo a Servethehome“Enfabrica tiene la tecnología más genial”, probablemente debido a su enfoque único para resolver uno de los problemas de escala más grandes de la IA: vincular decenas de miles de chips informáticos para que puedan operar como un solo sistema sin desperdiciar recursos.

Este acuerdo sugiere que NVIDIA cree que resolver los cuellos de botella de interconexión de interconexión es tan crítico como asegurar la capacidad de producción de chips.

Un enfoque único para los tejidos de datos

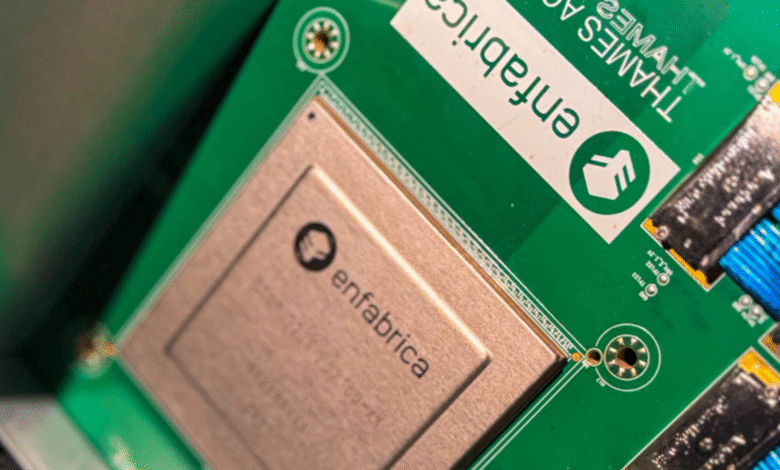

La arquitectura de interruptor de tela de cálculo acelerado de Enfabrica (ACF-S) se construyó con carriles PCIe en un lado y redes de alta velocidad en el otro.

Su dispositivo ACF-S “Millennium” es un chip de red de 3.2TBPS con 128 carriles PCIe que pueden conectar GPU, NIC y otros dispositivos mientras mantienen flexibilidad.

El diseño de la compañía permite que los datos se muevan entre puertos o a través del chip con una latencia mínima, unir tecnologías Ethernet y PCIe/CXL.

Para los grupos de IA, esto significa un mayor uso y menos GPU inactivas que esperan datos, lo que se traduce en un mejor retorno de la inversión para un hardware costoso.

Otra pieza de la oferta de Enfabrica es su chasis Emfasys, que utiliza controladores CXL para agrupar hasta 18 tb de memoria para grupos de GPU.

Esta tela de memoria elástica permite GPU para descargar datos de su memoria HBM limitada en almacenamiento compartido en toda la red.

Al liberar HBM para tareas críticas en el tiempo, los operadores pueden reducir los costos de procesamiento de tokens.

Enfabrica dijo que las reducciones podrían alcanzar hasta el 50% y permitir que las cargas de trabajo de inferencia se escalaran sin el desarrollo de la capacidad de memoria local.

Para modelos de idiomas grandes Y otras cargas de trabajo de IA, tales capacidades podrían volverse esenciales.

El chip ACF-S también ofrece redundancia de radio múltiple de alta radio. En lugar de unos pocos enlaces masivos de 800 Gbps, los operadores pueden usar 32 conexiones más pequeñas de 100 Gbps.

Si un interruptor falla, solo se pierde alrededor del 3% del ancho de banda, en lugar de una gran parte de la red que se desconecta.

Este enfoque podría mejorar la confiabilidad del clúster a escala, pero también aumenta la complejidad en el diseño de la red.

El acuerdo lleva al equipo de ingeniería de Enfabrica, incluido el CEO Rochan Sankar, directamente a Nvidia, en lugar de dejar tal innovación a rivales como Amd o Broadcom.

Mientras que Nvidia Intel La participación garantiza la capacidad de fabricación, esta adquisición aborda directamente los límites de escala en la IA centros de datos.