la versión original de esta historia apareció en Revista Quanta.

Aquí tienes una prueba para bebés: muéstrales un vaso de agua sobre una mesa. Escóndelo detrás de una tabla de madera. Ahora mueve el tablero hacia el cristal. Si el tablero sigue atravesando el cristal como si no estuviera allí, ¿se sorprenden? Muchos niños de 6 meses lo han hecho, y al año casi todos los niños tienen un sentido intuitivo de la permanencia de un objeto, aprendido a través de la observación. Ahora, algunos modelos de inteligencia artificial también lo hacen.

Los investigadores han desarrollado un sistema de inteligencia artificial que aprende sobre el mundo a través de videos y demuestra una sensación de “sorpresa” cuando se le presenta información que va en contra del conocimiento adquirido.

El modelo, creado por Meta y llamado Video Joint Embedding Predictive Architecture (V-JEPA), no hace suposiciones sobre la física del mundo contenido en los videos. Sin embargo, puedes empezar a entender cómo funciona el mundo.

“Tus afirmaciones son, a priori, muy verosímiles y los resultados son súper interesantes”, afirma Micha Heilbronun científico cognitivo de la Universidad de Amsterdam que estudia cómo los cerebros y los sistemas artificiales dan sentido al mundo.

Abstracciones superiores

Como saben los ingenieros que construyen vehículos autónomos, puede resultar difícil lograr que un sistema de inteligencia artificial dé sentido de manera confiable a lo que ve. La mayoría de los sistemas diseñados para “comprender” vídeos, clasificar su contenido (“una persona jugando al tenis”, por ejemplo) o identificar los contornos de un objeto (por ejemplo, un coche delante) funcionan en lo que se llama “espacio de píxeles”. Básicamente, el modelo trata cada píxel de un vídeo como de igual importancia.

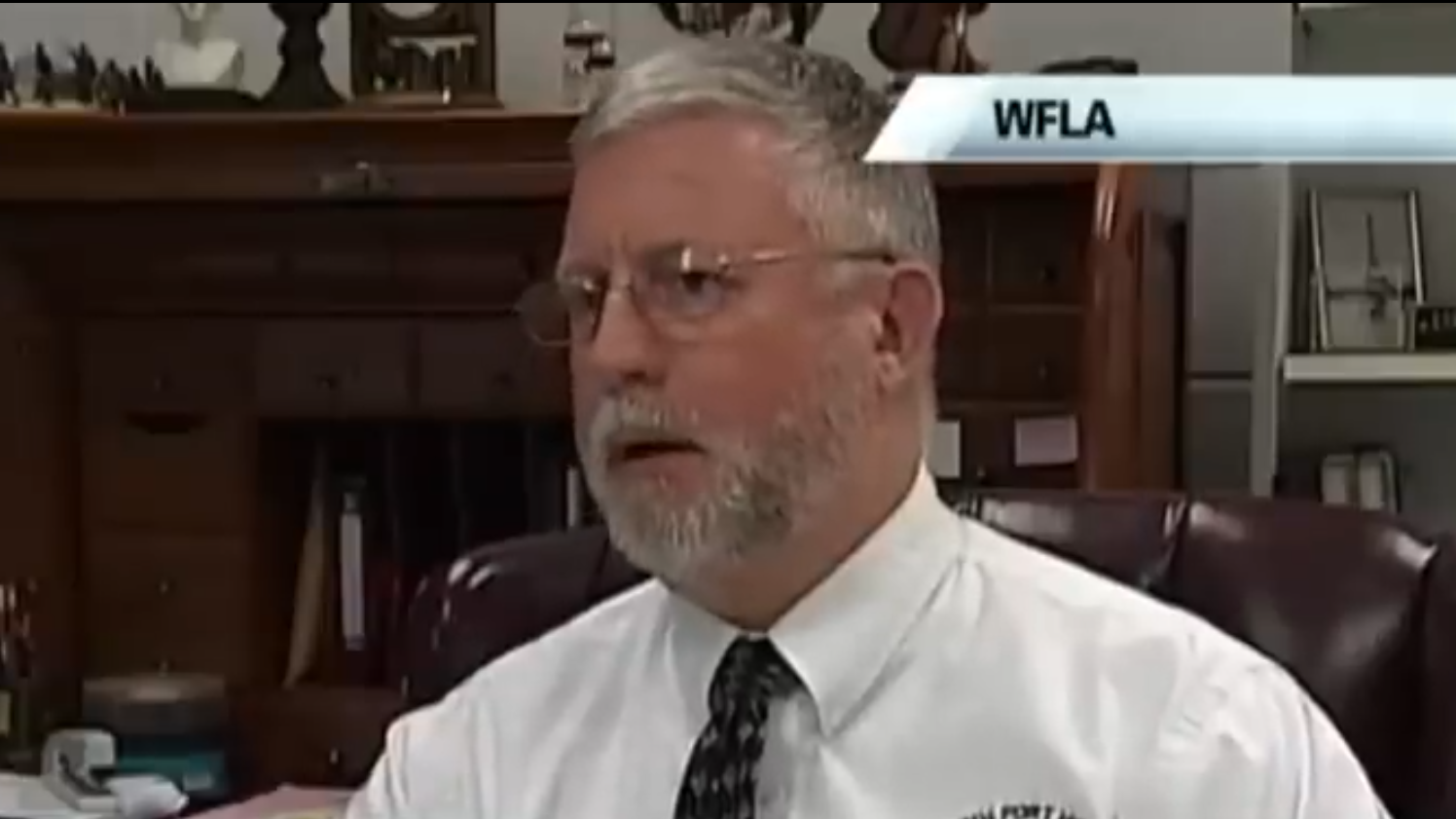

Pero estos modelos de espacio de píxeles tienen limitaciones. Imagínese intentar comprender una calle suburbana. Si la escena tiene coches, semáforos y árboles, el modelo puede centrarse demasiado en detalles irrelevantes, como el movimiento de las hojas. Es posible que pierdas el color del semáforo o la posición de los coches cercanos. “Cuando vas a imágenes o vídeos, no quieres trabajar en [pixel] espacio porque hay muchos detalles que no quieres modelar”, dijo. Randall Balestrieroinformático de la Universidad de Brown.